我们需要多大程度的理解AI工具的工作原理

一种称为深度学习人工智能已经开始补充或常见任务,如分析医学图像代替人类。波士顿乳腺成像部门负责人康斯坦斯·莱曼(ConstanceLehman)说:“在波士顿麻省总医院,我

一种称为深度学习人工智能已经开始补充或常见任务,如分析医学图像代替人类。波士顿乳腺成像部门负责人康斯坦斯·莱曼(Constance Lehman)说:“在波士顿麻省总医院,我们每年进行的50,000幅乳腺X线照片中的每一幅都通过深度学习模型进行处理,并将信息提供给放射线医生。” 。

在深度学习中,这是一种称为机器学习的人工智能类型的子集,计算机模型实质上是在自学以根据大量数据进行预测。近年来,这项技术的原始功能得到了极大的改善,现在已用于从医疗诊断到在线购物再到自动驾驶汽车的所有领域。

但是深度学习工具也引发了令人担忧的问题,因为它们以人类无法始终遵循的方式解决问题。如果您输入到模型中的数据与其提供的输出之间的联系是难以理解的(隐藏在所谓的黑匣子中),那么如何信任它?在研究人员中,越来越多的人要求澄清深度学习工具是如何做出决策的,并且就这种可解释性可能需要什么以及何时真正需要它进行了辩论。在医学上,赌注尤其高,因为生命将不断线上。

深度学习工具还提出了令人担忧的问题,因为它们以人类无法始终遵循的方式解决问题。

尽管如此,潜在的好处还是显而易见的。例如,在Mass General的乳房X线摄影程序中,当前的深度学习模型有助于检测致密的乳房组织,这是患癌的危险因素。麻省理工学院的计算机科学家雷曼(Lehman)和里贾纳·巴齐莱(Regina Barzilay)创建了另一种深度学习模型,用以预测女性五年内患乳腺癌的风险,这是规划护理的重要组成部分。在2019年对约40,000名女性的乳房X线照片的回顾性研究中,研究人员发现深度学习系统在约4,000名女性的测试集上明显优于当前的金标准方法。现在正在接受进一步测试,新模型可能会在医院进入常规临床实践。

至于关于人类是否真的可以理解深度学习系统的争论,Barzilay坚定地坐在营地中。她称黑匣子问题为“神话”。

她说,神话的一部分是深度学习系统无法解释其结果。她说:“但是,机器语言中有很多方法可以让您解释结果。”在她看来,神话的另一部分是医生必须了解系统如何做出决定才能使用它。但是,医学上充斥着先进技术,这些先进技术以临床医生真正不了解的方式工作,例如,磁共振成像(MRI)最初会收集乳房X线照相术的数据。

但这并不能解决所有医生的担忧。一组医生和研究人员在BMJ Clinical Research的最新论文中指出,许多机器学习工具仍然是“黑匣子”,“在没有任何附带理由的情况下做出结论”。该论文的作者继续说:“许多人认为,作为一种新技术,举证责任在于机器学习来说明其预测。”“如果医生不理解该算法为何能做出诊断,那么为什么患者应该信任推荐的治疗方案?”

卡内基梅隆大学的计算机科学家Zachary Lipton说,在研究机器学习的计算机科学家中,“关于可解释性的讨论已经完全脱离了轨道。”他说,通常为解释性提供的模型不能很好地工作,而且对于系统实际提供的内容存在困惑。

他补充说:“我们在现场的人有能力曲柄,但实际上不知道自己在做什么,并且实际上不了解他们在做什么的基础。”

-

12月09日布伦特伍德的家居用品商店捐赠了10000个N95防毒面具

-

12月09日Breakingviews-很容易喜欢Facebook成为Reliance的朋友

-

12月09日报春花以新的有趣Pods瞄准1.75亿英镑的奶酪零食市场

-

12月09日Blount宣布Scooter Bay销售公司是最新的零售赢家

-

12月09日英敏特发现美容公司无法满足西班牙人的需求

-

12月09日冠状病毒爆发后合作社启动了招募活动并紧急呼吁食品银行

-

12月09日欧洲股市因油价暴跌而下跌

-

12月09日ETF和股票无视9月零售疲弱

全站头条

-

宝藏公司将克里斯?考瓦特加入其管理团队 继续推动减少食物浪费的技术 克里斯·考阿特(ChrisCowart)IDEO的长期产品设计师,奇点大学的教职员工以及各种

宝藏公司将克里斯?考瓦特加入其管理团队 继续推动减少食物浪费的技术 克里斯·考阿特(ChrisCowart)IDEO的长期产品设计师,奇点大学的教职员工以及各种 -

蚂蚁庄园怎么雇佣小鸡工作 8个小时内需要及时来喂小鸡 蚂蚁庄园如何雇佣小鸡?蚂蚁庄园中上线芭芭农场后,又开放了雇佣小鸡功能,大家可以雇佣

蚂蚁庄园怎么雇佣小鸡工作 8个小时内需要及时来喂小鸡 蚂蚁庄园如何雇佣小鸡?蚂蚁庄园中上线芭芭农场后,又开放了雇佣小鸡功能,大家可以雇佣 -

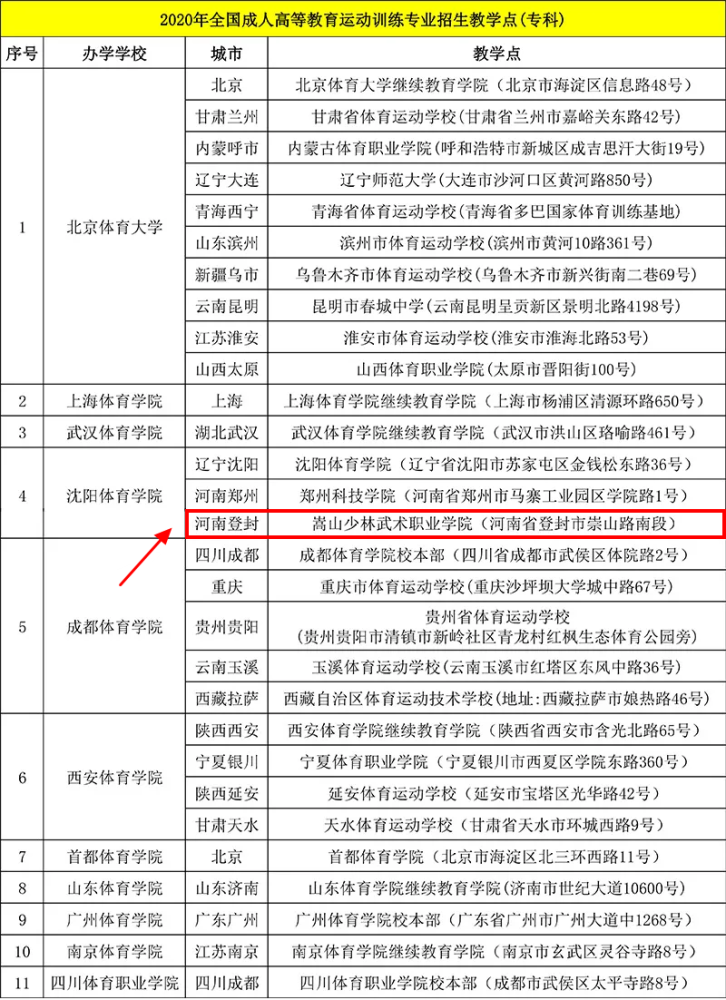

嵩山少林武术职业学院成为沈阳体育学院一专业招生教学点 近日,国家体育总局科教司发布关于2020年成人高等教育运动训练专业招生教学点名单的公

嵩山少林武术职业学院成为沈阳体育学院一专业招生教学点 近日,国家体育总局科教司发布关于2020年成人高等教育运动训练专业招生教学点名单的公 -

谷歌Pixel 4a蓝色版上市 采用5.81英寸屏幕和骁龙730G 谷歌的Pixel4a此前只提供一个颜色的版本——JustBlack(只是黑色),现在该机

谷歌Pixel 4a蓝色版上市 采用5.81英寸屏幕和骁龙730G 谷歌的Pixel4a此前只提供一个颜色的版本——JustBlack(只是黑色),现在该机 -

摩根士丹利利润暴跌 警告未来将面临更多痛苦 摩根士丹利(MS.N)首席执行官詹姆斯·戈曼(JamesGorman)警告说,由于冠状病毒危机

摩根士丹利利润暴跌 警告未来将面临更多痛苦 摩根士丹利(MS.N)首席执行官詹姆斯·戈曼(JamesGorman)警告说,由于冠状病毒危机